![]()

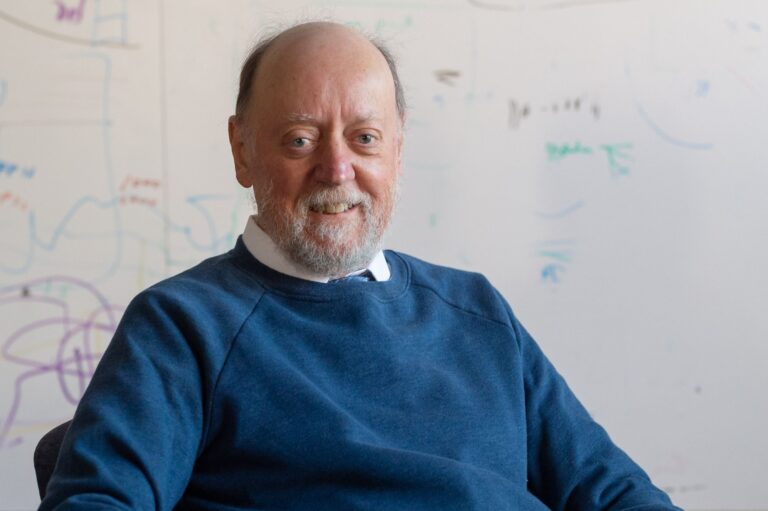

Premio ACM Turing: Jack Dongarra

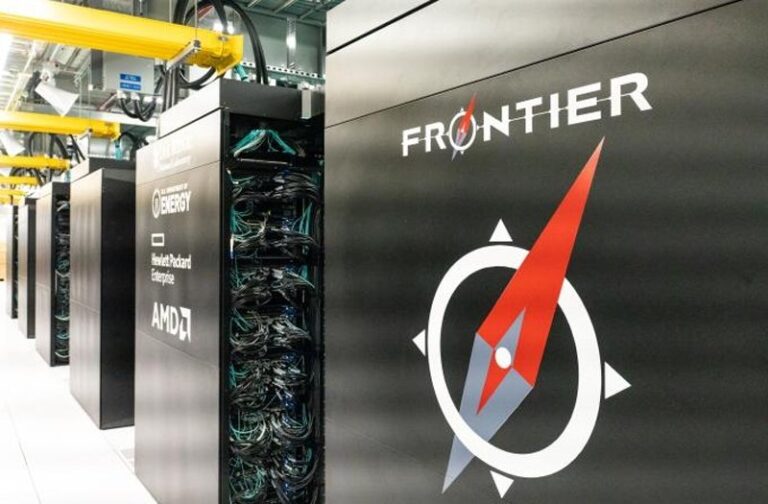

El ranking bianual de la supercomputación, Top500, nació en 1993 y este mismo mes de junio ha cumplido su 59ª edición, dejando en el podium al supercomputador Frontier, una bestia de AMD. A grandes rasgos, a este ranking se presentan (públicamente) las instalaciones de supercomputación más importantes del mundo para ejecutar una batería de pruebas mediante unos algoritmos y terminar baremados en base a los resultados que obtienen. El benchmark que se utiliza es el LINPACK, descrito en el technical report…