![]()

La Computación del Trillón

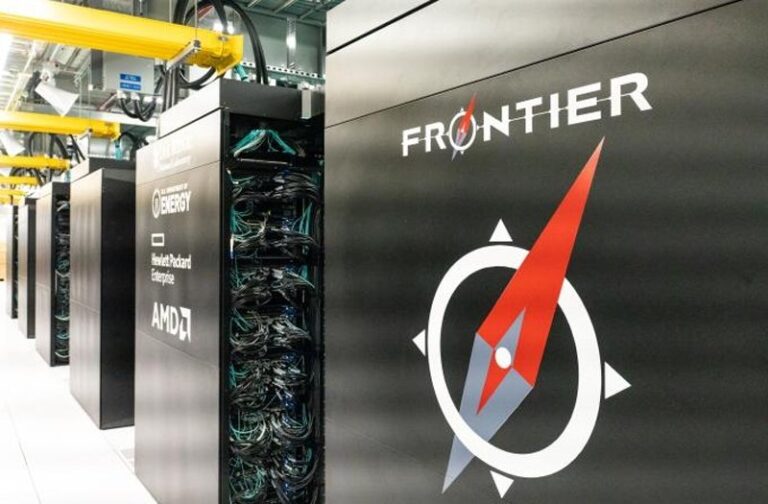

Dos años después de las previsiones más pesimistas (pandemia mediante), llegamos al nivel de la exaescala en computación con la instalación de Oak Ridge National Laboratory, Frontier. Las previsiones en 2011 más optimistas hablaban de 2017, y las más realistas en la horquilla de 2018-2020; pero no ha sido hasta mediados de 2022 cuando se ha dado a conocer la primera instalación de supercomputación capaz de realizar 1018 operaciones en coma flotante por segundo, es decir, 1 millón de «billones…