![]()

Inteligencia Artificial: La Bola de Cristal de la Tecnociencia (Publicaciones Científicas)

Fuente: Colaje imágenes Google

Los líderes tecnológicos deben «devolver» a la sociedad para apoyar el bien común

En nuestro post “Inteligencia Artificial A Gritos en la Oscuridad (atrapados y sin salida)“ ya os narré, mi aprensión por la eclosión ilegal de la IA generativa por cuanto invadió mi privacidad de un modo escandaloso, mediante un artilugio comercial que habían regalado a mi pareja para poner música. “Incluso apagado lo escuchaba todo ( pero no el enchufe a la corriente), pudiendo hablar con ella unos minutos. a “petición suya”. Es decir, estaba espiándonos a todos a lo largo del del día. Más que invasión de la privacidad yo lo llamaría espionaje en el sentido estricto del término. Muy pocos años después, sin respetar a nada y a nadie, las compañías tecnológicas que lo implantan habían violado todos los derechos de autor, mientras que las mismas corporaciones digitales amasan miles y miles de millones de euros de forma palmariamente ilegal. Y mientras tanto las autoridades, continúan a paso de tortuga intentando redactar nomas para regularizar su uso ¿? Obviamente, ya veréis como en algunas de las noticias que os muestro abajo, se habla del tema abundantemente.

Seguidamente, editamos otro post “IA y Tecnociencia (Inteligencia Artificial)”, expresando nuestra opinión y finalmente en una tercera entradilla “Las Dos Caras de la Inteligencia Artificial y Sus Algoritmos” os mostré porque debemos desconfiar mucho de ella, por cuanto las modelizaciones no aportan nada si no podemos entender/interpretar el significado de sus algoritmos, como es el caso. La ciencia estriba en avanzar, haciendo retroceder el muro de nuestra ignorancia acerca del mundo que nos rodea. Incluso si la bola de cristal de la tecnociencia acertara, poco o nada entenderíamos, ya que reitero que sus algoritmos son indescifrables, al menos a día de hoy . Su uso se ha extendido ya por doquier y los ciudadanos parecemos como adolescentes con un nuevo juguete que está de moda, a pesar de que otros muchos expertos vaticinan también que puede llevar nuestra sociedad hacia el abismo, incluyendo entre los críticos a algunos de sus creadores y/o promotores iniciales.

Sin embargo, tras leer la siguiente noticia, han vuelto a revelarse mis humildes neuronas orgánicas: “Los artículos científicos que mencionan la IA reciben un aumento en las citas”

«Los artículos con títulos o resúmenes que mencionan ciertos métodos de inteligencia artificial (IA) tienen más probabilidades de estar entre el 5% de los trabajos más citados en su campo durante un año determinado que aquellos que no hacen referencia a esas técnicas, según un análisis. Estos artículos también tienden a recibir más citas de fuera de su campo que los estudios que no se refieren a términos de IA”.

Personalmente puedo confirmarlo, ya que me han solicitado formar parte de varias revisiones por pares y aparecen por doquier la IA, aprendizaje automático y bla, bla). Obviamente los resultados van acompañados por especulaciones de los autores nada más. Eso no es ciencia en el sentido estricto del término. Francamente no logro entenderlo, ya que todo apunta que pensamos como si fueramos adolescentes que se afanan en estar a la última moda bajo el lema (burro grande ande o no ande) y el palabro grande debe entenderse, en este contexto, como estar a la moda. Empero, si no se entiende el algoritmo, como nos dedicamos ahora a bombardear le revista con predicciones que ni tan siquiera podemos descifrar. Lo dicho, si la bola de cristal de la tecnociencia. Y como corolario, el método científico descarrila gracias a nuestros esfuerzos. Ocurrirá como los modelos de Circulación General de la Atmósfera y los Océanos, separados o desecoplados. Dado que las predicciones generales fallaban como una metralleta, se iban cambiando por otros nuevos, con regularidad, y así las predicciones anteriores pasaban al limbo de los justos (eran soslayadas). Empero incluso así se había publicado un texto y sin los indescifrables algoritmos-IA se podría intentar escudriñar en que se fallaba, datos y premisas de los modelos, etc. Llagada la moda de la IA topamos con la bola de cristal de la tecnociencia, ni tan siquiera eso.

Y reitero que mento como la IA de lenguaje natural, generativa o no, ya en manos de expertos y para propósitos concretos, si pueden ser de gran utilidad en muchos campos del conocimiento. Pero en el universo de la Tecnociencia se pudren, soslayan y olvidad demasiadas cosas, como los cánones del propio método científico por aquellos que debían ser sus guardianes.

¿El ocaso del método científico?. Pues…..

Juan José Ibáñez

Continúa……

Algunos conceptos básicos

“Inteligencia artificial generativa“ “Aprendizaje automático”

A la inteligencia artificial se le da muy bien para encontrar patrones en los datos, pero este enfoque no revela la causa-efecto de las cosas y resulta muy limitado para entender el mundo real. Un investigador acaba de presentar una estrategia que podría conseguir que la IA analice las relaciones causales

Post Previos

“Inteligencia Artificial A Gritos en la Oscuridad (atrapados y sin salida)”

“IA y Tecnociencia (Inteligencia Artificial)”

“Las Dos Caras de la Inteligencia Artificial y Sus Algoritmos”

Artículos y prensa científica relacionada (ejemplos)

¿Qué debemos hacer si la IA se vuelve consciente? Estos científicos dicen que es hora de un plan

¿El uso de herramientas de IA es innovación o explotación? Tres maneras de pensar la ética

“Los artículos científicos que mencionan la IA reciben un aumento en las citas”

Un análisis de decenas de millones de artículos muestra qué campos han adoptado las herramientas de IA con entusiasmo, y cuáles han sido más lentos.

Los artículos con títulos o resúmenes que mencionan ciertos métodos de inteligencia artificial (IA) tienen más probabilidades de estar entre el 5% de los trabajos más citados en su campo durante un año determinado que aquellos que no hacen referencia a esas técnicas, según un análisis1. Estos artículos también tienden a recibir más citas de fuera de su campo que los estudios que no se refieren a términos de IA.

Pero este «aumento de citas» no fue compartido por igual por todos los autores. El análisis también mostró que los investigadores de grupos que históricamente han estado infrarrepresentados en la ciencia no obtienen el mismo aumento en las citas que sus homólogos cuando utilizan herramientas de IA en su trabajo, lo que sugiere que la IA podría exacerbar las desigualdades existentes.

IA y ciencia: lo que piensan 1.600 investigadores

Los hallazgos surgieron de un estudio que tenía como objetivo cuantificar el uso y los beneficios potenciales de la IA en la investigación científica. Pero el informe, publicado la semana pasada en Nature Human Behaviour, también plantea preocupaciones. Los científicos podrían verse incentivados a usar la IA simplemente como una forma de aumentar sus citas, independientemente de si las herramientas de IA mejoran la calidad del trabajo, señala Lisa Messeri, antropóloga de ciencia y tecnología de la Universidad de Yale en New Haven, Connecticut. «Queremos asegurarnos de que, a medida que estamos [invirtiendo] en IA, no lo estamos haciendo en detrimento de otros enfoques«, dice.

El estudio también proporciona una cuantificación muy necesaria de cómo la IA está cambiando la investigación científica, dice Dashun Wang, coautor del estudio y científico social computacional que estudia la ciencia de la ciencia en la Universidad Northwestern en Evanston, Illinois. «Ahora finalmente tenemos datos sistemáticos», dice Wang, que serán fundamentales para abordar las disparidades relacionadas con el uso de la IA en la ciencia.

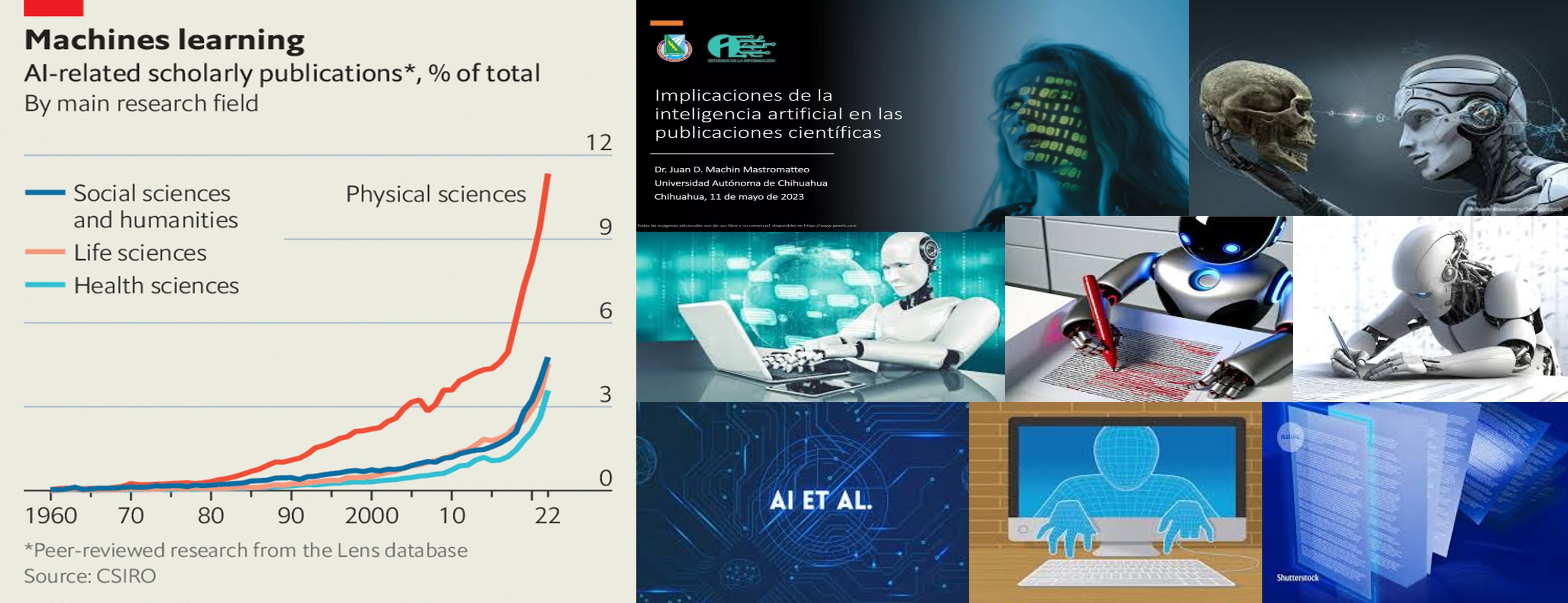

Rastreando el auge de la IA

Para medir el compromiso de los científicos con la IA, los autores identificaron términos relacionados con la IA, como «aprendizaje automático» y «red neuronal profunda», en los resúmenes y títulos de casi 75 millones de artículos, que abarcan 19 disciplinas, que se publicaron entre 1960 y 2019. Wang reconoce que, debido a la fecha límite, el estudio no capta los desarrollos recientes en IA, incluido el aumento de grandes modelos de lenguaje como ChatGPT, que ya están cambiando la forma en que algunos investigadores hacen ciencia.

Según el estudio, los científicos de las 19 disciplinas han intensificado el uso de herramientas de IA en las últimas dos décadas (véase «El uso de la IA despega»). Pero hay una gran variación: las ciencias de la computación, las matemáticas y la ingeniería tienen las tasas más altas de uso de la IA, y la historia, el arte y las ciencias políticas tienen las más bajas. Las tasas de geología, física, química y biología están en el medio.

Para estimar los beneficios potenciales de la IA para cada disciplina, los autores primero identificaron las tareas relacionadas con la investigación que la IA puede realizar. Luego, rastrearon el aumento de estas capacidades a lo largo del tiempo mediante la detección de ciertos pares de verbos y sustantivos, como ‘analizar datos’ y ‘generar imagen’, en publicaciones sobre IA entre 1960 y 2019. Al observar cuánto se superponían estos términos en las publicaciones relacionadas con la IA con las tareas básicas de un campo de investigación determinado a lo largo del tiempo, los investigadores pudieron evaluar si las capacidades de la IA podían satisfacer las necesidades cambiantes de ese campo. Una vez más, las ciencias de la computación, las matemáticas y la ingeniería se asociaron con los beneficios potenciales más altos, y la historia, el arte y las ciencias políticas con los más bajos.

Marinka Zitnik, especialista en informática biomédica de la Escuela de Medicina de Harvard en Boston, Massachusetts, dice que el enfoque del artículo es interesante porque permite un análisis sistemático de varias disciplinas científicas. Pero tiene sus limitaciones. «Debido a que los autores querían hacer un estudio muy amplio y sistemático, eso significaba que no necesariamente podían entrar en una comprensión muy intrincada de por qué un verbo o sustantivo específico aparecería en un artículo», dice. El hecho de que ciertos verbos y sustantivos aparezcan juntos en un trabajo no significa que, si la IA puede realizar la tarea descrita, necesariamente será útil para ese campo, señala.

doi: https://doi.org/10.1038/d41586-024-03355-9

Referencias

Gao, J. y Wang, D. Naturaleza Hum. Behav. https://doi.org/10.1038/s41562-024-02020-5 (2024).

Carissa Véliz, filósofa en Oxford: «La IA está diseñada para inventar contenidos verosímiles, no para buscar la verdad»

Esta experta en filosofía moral y tecnología alerta de los riesgos para la democracia de las inteligencias artificiales.

La filósofa de Oxford Carissa Véliz, en Madrid. — P. R.; MADRID; 19/10/2024 21:31

Hablar unos minutos con Carissa Véliz, profesora asociada en el Instituto para la ética de la inteligencia artificial y miembro del Hertford College de la Universidad de Oxford, es una experiencia profundamente didáctica y, al mismo, tiempo, serena. Autora de varias obras de referencia sobre vigilancia y privacidad, ahora enseña a empresas y gobiernos a considerar la finalidad del uso de las IA y los peligros que entraña ignorar sus riesgos, incluso para el propio sistema democrático.

«Al final, la democracia depende de tener información fiable y de que los ciudadanos estén relativamente bien informados«, explica Véliz a Público, «y si tienes una máquina cuya especialidad es inventarse historias que son plausibles y verosímiles, pero no verdad, y facilita la generación de estos contenidos a escala, pues evidentemente hay un problema de desinformación«. Esta renombrada experta, reciente participante estrella en el Foro Líderes con Propósito en Madrid, reivindica un abordaje serio de los problemas éticos que pueden generar estas tecnologías porque «hay diferentes tipos de inteligencia artificial, diferentes empresas, diferentes usos, y hay quien se toma en serio la inteligencia artificial y hay quien no; necesitamos que todo el mundo se lo tome en serio«, afirma. De hecho, ella misma imparte un curso sobre ética de la IA en la Fundación Rafael del Pino enfocado al mundo empresarial.

«Europa de nuevo va a la cabeza en regulación [sobre inteligencia artificial], pero creo que las leyes tienen que ser minimalistas», apunta Véliz, cuyo enfoque sobre el asunto legislativo tiene que ver con la protección de los derechos de los ciudadanos, más allá del análisis de coste-beneficio. «Es normal que la tecnología vaya por delante de las leyes, y creo que es un enfoque bueno que la legislación se fije en los fines de su uso más que en la tecnología en particular, porque la tecnología cambia todo el rato«, comenta, aunque añade: «Es verdad que existe el riesgo de que de que no estemos haciendo una asesoría correcta». Porque, aunque tengamos una normativa básica pero clara sobre qué limites son necesarios en el despliegue de las inteligencias artificiales, algunos requisitos, como la evaluación de riesgos, son poco menos que imposibles de cumplir ya que las IA fundacionales son, naturalmente, opacas y casi nadie sabe cómo funcionan realmente.

Washington actúa ya contra las mentiras generadas con inteligencia artificial

Estimar los riesgos

Para Véliz, «es muy difícil tener una estimación real de los riesgos cuando existen tecnologías con las que no hemos interactuado antes, no hay datos para calcular ese riesgo adecuadamente«, aunque sostiene que analizar los fines de la herramienta, aunque sea una IA fundacional multipropósito, es un buen camino de inicio.

«Al final la IA es una herramienta, sofisticada, pero una herramienta; por lo tanto, los seres humanos que están detrás de esa herramienta son responsables» de esos motores de IA. ”Las tecnológicas han ignorado la ley y diseñado un sistema de manera ilegal«.

La experta recuerda, para empezar, que «las tecnológicas han ignorado la ley y diseñado un sistema de manera ilegal, o sea, tomando datos que tenían derechos de autor, datos personales, todo lo que han podido barrer en internet», hasta el momento «parece que hemos aceptado ese hecho», y «ahora tenemos la contradicción de que estamos utilizando esas herramientas que no cumplen ni siquiera con las normas de derechos de autor ni con el reglamento de protección de datos, pero esas normas siguen vigentes«.

Porno infantil, violencia, machismo: ¿qué hacemos si la inteligencia artificial produce monstruos?

Acerca del reciente premio Nobel de Física George Hinton, Véliz nos cuenta una historia: «George Hinton fue recientemente a Oxford y tuve la oportunidad de hablar con él; durante la charla explicó lo que estamos haciendo con la inteligencia artificial, algo que se ha vuelto muy peligroso y que incluso está diseñado de una manera que realmente pone en riesgo a la democracia e incluso a la ciencia. Yo le pregunté: Bueno, si realmente supone un riesgo incluso existencial, si usted volviera a vivir de nuevo, ¿qué haría diferente? Y me dijo que no cambiaría nada, que lo haría todo igual«. Aún con todo, Véliz se muestra optimista porque está segura de que «hay maneras de diseñar la tecnología para que la entendamos mejor, para que sea más responsable». Y se debe calibrar la importancia real de cualquier tecnología nueva. «Al principio había mucho hype en las empresas pero la realidad es que muchas de ellas no han encontrado suficientes mejoras en la productividad como esperaban».

Ahorro o pérdida de tiempo

Si la IA «se inventa algo muy complicado de comprobar, se pierde tanto tiempo editando y corrigiendo errores que parece que el trabajo lo hace una«, comenta esta experta, que señala que «de momento la gente sobre todo usa las herramientas de IA por curiosidad, por diversión, para escribir algún email poco importante; está por ver qué usos serán realmente importantes«.

El enorme lío de las imágenes ‘creadas’ por robots: derechos de autor, falsedad, manipulación…

La adopción de herramientas con IA generativa se está extendiendo en muchísimos campos y pueden ahorrar tiempo a la hora de generar un documento o editar una imagen. No obstante, la velocidad de su desarrollo está creando una nueva generación que no sólo la usa despreocupadamente para escribir trabajos en el sistema educativo, por ejemplo, sino que se está desacostumbrando a contrastar si la información que le devuelve el sistema es verdadera o falsa.

Véliz acaba de terminar un capítulo de su nuevo libro Privacidad es poder (Debate, 2024) en el que propone varios casos de ciertas pérdidas de habilidades que nos pueden costar caro. Uno de ellos se refiere a las plantas de energía, «que, cuando son hackeadas, tienen que funcionar manualmente, analógicamente, y la gente nueva quizá no tenga esa experiencia, de modo que tienen que llamar a personas veteranas, ya retiradas, para que ayuden». «Pero los veteranos que controlan analógicamente estos sistemas no van a estar ahí toda la vida, de modo que cuando falten, ¿qué vamos a hacer?«, se pregunta.

La ética del buen diseño

Durante su charla en el evento Líderes con futuro, Carissa Véliz utilizó, ante un nutrido grupo de empresarios y expertos, varios casos que demuestran hasta qué punto el uso de las inteligencias artificiales ha de abordarse con cuidado. «No están entrenadas para pensar ni, por tanto, conocer sus propios límites de conocimiento«, dijo. Para ella «son generadoras de respuestas estadísticas que no buscan la verdad sino la plausibilidad, la verosimilitud«. O sea, para que nos la creamos.

Por ello, la ética es fundamental en el diseño de estas poderosas herramientas, y el asunto de la privacidad personal frente a las IA es nuclear. «No le pidas a una IA que te facilite tus propios datos personales, esos que ha utilizado durante su entrenamiento, porque no te los va a entregar, ya que su forma de actuar se basa en esos mismos datos», remarcó al tratar el asunto de la privacidad individual y las inteligencias artificiales, ávidas estas últimas de datos para poder funcionar.

«Sin privacidad no hay verdadera democracia«, afirmó Véliz, que concluyó que «la pregunta sería cuánta vigilancia puede soportar una democracia«.

ChatGPT está transformando la revisión por pares: ¿cómo podemos usarla de manera responsable?

En las principales publicaciones de ciencias de la computación, hasta el 17% de las revisiones por pares ahora están escritas por inteligencia artificial. Necesitamos directrices antes de que las cosas se nos vayan de las manos.

Por James Zou

Desde que se lanzó el chatbot de inteligencia artificial (IA) ChatGPT a finales de 2022, los informáticos han notado una tendencia preocupante: los chatbots se utilizan cada vez más para revisar trabajos de investigación que terminan en las actas de las principales conferencias.

Hay varios signos reveladores. Las reseñas escritas por herramientas de IA destacan por su tono formal y su verbosidad, rasgos comúnmente asociados con el estilo de escritura de los grandes modelos de lenguaje (LLM). Por ejemplo, palabras como encomiable y meticuloso son ahora diez veces más comunes en las revisiones por pares que antes de 2022. Las revisiones generadas por IA también tienden a ser superficiales y generalizadas, a menudo no mencionan secciones específicas del artículo presentado y carecen de referencias.

Esté lista o no, la IA está llegando a la educación científica, y los estudiantes tienen opiniones

Eso es lo que descubrimos mis colegas y yo de la Universidad de Stanford, en California, cuando examinamos unas 50.000 revisiones por pares de artículos de ciencias de la computación publicados en actas de conferencias en 2023 y 2024. Estimamos que entre el 7 y el 17% de las frases de las reseñas fueron escritas por LLM basándose en el estilo de escritura y la frecuencia con la que aparecen ciertas palabras (W. Liang et al. Proc. 41ª Int. Conf. Mach. Aprender. 235, 29575–29620; 2024).

La falta de tiempo podría ser una de las razones para utilizar los LLM para escribir revisiones entre pares. Descubrimos que la tasa de texto generado por LLM es mayor en las reseñas que se enviaron cerca de la fecha límite. Esta tendencia no hará más que intensificarse. Los editores ya luchan por asegurar revisiones oportunas y los revisores están abrumados con las solicitudes.

Afortunadamente, los sistemas de IA pueden ayudar a resolver el problema que han creado. Para ello, el uso de LLM debe restringirse a tareas específicas, como corregir el lenguaje y la gramática, responder a preguntas sencillas relacionadas con el manuscrito e identificar información relevante, por ejemplo. Sin embargo, si se utilizan de manera irresponsable, los LLM corren el riesgo de socavar la integridad del proceso científico. Por lo tanto, es crucial y urgente que la comunidad científica establezca normas sobre cómo utilizar estos modelos de manera responsable en el proceso de revisión académica por pares.

Propiedad intelectual y privacidad de datos: los riesgos ocultos de la IA

En primer lugar, es esencial reconocer que la generación actual de LLM no puede reemplazar a los revisores humanos expertos. A pesar de sus capacidades, los LLM no pueden exhibir un razonamiento científico profundo. A veces también generan respuestas sin sentido, conocidas como “alucinaciones”. Una queja común de los investigadores que recibieron revisiones de sus manuscritos escritas por LLM fue que la retroalimentación carecía de profundidad técnica, particularmente en términos de crítica metodológica (W. Liang et al. NEJM AI 1, AIoa2400196; 2024). Los LLM también pueden pasar por alto fácilmente los errores en un trabajo de investigación.

Teniendo en cuenta estas advertencias, se requiere un diseño bien pensado y unas barandillas de protección al desplegar LLM. Para los revisores, un asistente de chatbot de IA podría proporcionar comentarios sobre cómo hacer que las sugerencias vagas sean más procesables para los autores antes de que se envíe la revisión por pares. También podría destacar secciones del artículo, potencialmente omitidas por el revisor, que ya abordan las preguntas planteadas en la revisión.

Para ayudar a los editores, los LLM pueden recuperar y resumir documentos relacionados para ayudarlos a contextualizar el trabajo y verificar el cumplimiento de las listas de verificación de presentación (por ejemplo, para garantizar que las estadísticas se informen correctamente). Se trata de aplicaciones de LLM de riesgo relativamente bajo que podrían ahorrar tiempo a los revisores y editores si se implementan bien.

Sin embargo, los LLM pueden cometer errores incluso cuando realizan tareas de recuperación y resumen de información de bajo riesgo. Por lo tanto, los resultados de LLM deben verse como un punto de partida, no como la respuesta final. Los usuarios aún deben verificar el trabajo del LLM.

ChatGPT un año después: ¿quién lo utiliza, cómo y por qué?

Las revistas y conferencias pueden verse tentadas a utilizar algoritmos de IA para detectar el uso de LLM en revisiones por pares y artículos, pero su eficacia es limitada. Aunque estos detectores pueden resaltar casos obvios de texto generado por IA, son propensos a producir falsos positivos, por ejemplo, marcando el texto escrito por científicos cuya lengua materna no es el inglés como generado por IA. Los usuarios también pueden evitar la detección solicitando estratégicamente el LLM. Los detectores a menudo tienen dificultades para distinguir los usos razonables de un LLM (para pulir el texto sin procesar, por ejemplo) de los inapropiados, como el uso de un chatbot para escribir el informe completo.

En última instancia, la mejor manera de evitar que la IA domine la revisión por pares podría ser fomentar más interacciones humanas durante el proceso. Plataformas como OpenReview animan a los revisores y autores a tener interacciones anónimas, resolviendo preguntas a través de varias rondas de discusión. OpenReview está siendo utilizado por varias de las principales conferencias y revistas de ciencias de la computación.

La ola de uso de LLM en la escritura académica y la revisión por pares no se puede detener. Para navegar por esta transformación, las revistas y los lugares de conferencias deben establecer directrices claras y poner en marcha sistemas para hacerlas cumplir. Como mínimo, las revistas deben pedir a los revisores que revelen de forma transparente si utilizan los LLM y cómo lo hacen durante el proceso de revisión. También necesitamos plataformas innovadoras e interactivas de revisión por pares, adaptadas a la era de la IA, que puedan restringir automáticamente el uso de los LLM a un conjunto limitado de tareas. Paralelamente, necesitamos mucha más investigación sobre cómo la IA puede ayudar de manera responsable con ciertas tareas de revisión por pares. El establecimiento de normas y recursos comunitarios ayudará a garantizar que los LLM beneficien a los revisores, editores y autores sin comprometer la integridad del proceso científico.

Naturaleza 635, 10 (2024)

doi: https://doi.org/10.1038/d41586-024-03588-8

La encuesta destaca la disparidad entre el acceso de los científicos académicos y de la industria a la potencia informática necesaria para entrenar modelos de aprendizaje automático.

El director general de Google DeepMind enfría las expectativas en torno al progreso de esta tecnología,….

Noticias

La IA es una amenaza para el planeta: consume más electricidad que muchos países

La fiebre de la inteligencia artificial revive la demanda de energía nuclear, gas y petróleo

Las necesidades energéticas de la IA provocan un auge de las nucleares en Estados Unidos

La economía mundial transformada por la inteligencia artificial ha de beneficiar a la humanidad

Google pone cifras al impacto en el PIB de la IA generativa: 120.000 millones en una década

Ni Microsoft, ni Google: esta es la compañía que más dinero gana con la inteligencia artificial

Las grandes tecnológicas baten récords de ingresos y beneficios por la inteligencia artificial: Alphabet, Apple, Amazon, Meta y Microsoft ganaron 96.720 millones de dólares en el tercer trimestre, un 12% más que un año antes

La IA y su voraz consumo de energía atentan contra los objetivos climáticos: La inteligencia artificial está teniendo un profundo impacto en la demanda de energía en todo el mundo, está provocando aumentos frecuentes de las emisiones que calientan el planeta y no hay un final a la vista…

Los expertos son optimistas sobre los avances en la energía y la producción de medicamentos, pero también temen su posible uso indebido.

Los nuevos asistentes de los matemáticos son artificialmente inteligentes

La colaboración entre la IA y los humanos podría alcanzar una grandeza

Elon Musk y su ‘libertad de expresión’: desvelan que el algoritmo de X priorizó el apoyo a Trump

La investigación basada en la IA podría causar un daño inmenso si se utiliza para diseñar patógenos con nuevas propiedades preocupantes. Para evitarlo, necesitamos una mejor colaboración entre los gobiernos, los desarrolladores de IA y los expertos en bioseguridad y bioseguridad.

ChatGPT cumple dos años: cómo el chatbot de IA ha cambiado la vida de los científicos

El ochenta y uno por ciento de los encuestados dijo que había usado ChatGPT personal o profesionalmente, lo que lo convierte, con mucho, en la herramienta más popular entre los académicos

La inteligencia artificial revoluciona la investigación espacial

Conceptos Básicos

Qué son los algoritmos de inteligencia artificial?

En términos sencillos, los algoritmos de inteligencia artificial son un conjunto de reglas y procesos que las máquinas utilizan para realizar tareas que normalmente requieren inteligencia humana. Estos algoritmos aprovechan grandes cantidades de datos y cálculos para aprender, tomar decisiones y resolver problemas. La evolución de tecnologías como la nube, la computación y el big data ha hecho que la inteligencia artificial sea más accesible y eficiente.

“La IA empieza a centrarse en la causas en lugar de las correlaciones»

A la inteligencia artificial se le da muy bien para encontrar patrones en los datos, pero este enfoque no revela la causa-efecto de las cosas y resulta muy limitado para entender el mundo real. Un investigador acaba de presentar una estrategia que podría conseguir que la IA analice las relaciones causales

Nota del Bloger: Tras leer la noticia nada de nada. Tan solo alucinaciones”

Tipos de algoritmos de inteligencia artificial

Existen varios subgrupos dentro de los algoritmos de inteligencia artificial, cada uno con sus propias aplicaciones y técnicas. Los más destacados son:

Aprendizaje automático (machine learning)

Redes neuronales (neural networks)

Aprendizaje profundo (deep learning)

Procesamiento del lenguaje natural (NLP)

Tipos de algoritmos de Inteligencia artificial

¿Qué es la explicabilidad de la inteligencia artificial? Cómo quitarle misterio a la tecnología

Aprendizaje supervisado: es el tipo más común de algoritmo de inteligencia artificial. Se basa en el uso de conjuntos de datos de entrenamiento etiquetados para entrenar al modelo y luego aplicar ese aprendizaje a nuevos datos. Es útil para problemas como la clasificación, el reconocimiento de patrones, la segmentación de datos y la predicción.

Aprendizaje no supervisado: en este tipo de algoritmo, el modelo busca patrones y relaciones ocultas en los datos sin la ayuda de etiquetas o categorías. Es útil en aplicaciones como la segmentación de imágenes, la compresión de datos, la agrupación y la recomendación basada en intereses.

Redes neuronales: imita la forma en que el cerebro humano procesa la información. Utiliza nodos interconectados para capturar patrones y relaciones en los datos.

Algoritmos genéticos: se basa en la selección natural para encontrar soluciones óptimas a problemas. Utiliza técnicas de evolución para crear y seleccionar soluciones potencialmente óptimas.

Árboles de decisión: crea un modelo de decisiones a través de ramificaciones de opciones a partir de puntos de partida, para llegar a soluciones finales.

Aprendizaje en línea: utiliza datos que llegan en tiempo real, para aplicar los conocimientos obtenidos en situaciones de acción inmediatas. Cada uno de estos algoritmos tiene sus propias características y se utiliza para abordar diferentes tipos de problemas de inteligencia artificial.