![]()

h

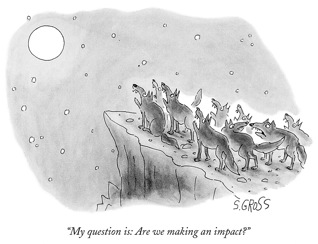

- Los evaluadores no examinan adecuadamente el contenido de la investigación, que es, a fin de cuentas, el objeto de examen;

- Los investigadores están sustituyendo la consecución de los objetivos científicos por la consecución de buenos resultados en los indicadores.

¿Cómo medir el impacto de la investigación? El principal producto de la investigación son los artículos, de ahí que una buena medida del impacto de los resultados de investigación sean las citas generadas por los mismos.

Se pueden hacer medidas indirecta de un autor por el factor de impacto de las revistas en las que publica, o medidas directa de las citas de cada uno de sus artículos.

En resumen, lo que se puede medir es:

- Número total de artículos

- Número total de citas

- Media de citas por artículo

- Número de artículos relevantes (por ejemplo, artículos con más de un número determinado de citas)

- Número de citas de cada uno de los más citados

Factor de Impacto

El Factor de Impacto (Impact Factor) FI fue introducido por Eugene Garfield, el fundador del Institute for Scientific Information (ISI), ahora parte de Thomson, y se calcula cada año para cada revista que está indexada en Thomson Scientific. La lista de estas revistas y sus impactos se publican en el Journal Citation Reports.

Esta es su definición:

FI del año n = (citas del año n a artículos de los años n-2 y n-1)/(artículos de los años n-2 y n-1)

Un problemas que se señala frecuentemente es que el numerador y el denominador no pertenecen al mismo universo; en el denominador están artículos decididos “a mano” (“front matter” papers), lo que puede llevar a una “negociación” para incluir sólo aquellos que generen más citas.

Otras críticas son que está centrado en el mundo anglosajón, hay dificultades con los nombres de los autores, hay un sesgo de las personas implicadas en el Comité Editorial de la revista, existen las llamadas citas “cremoniales” a obras que no se han leído pero son de “obligada cita”, o citas negativas que son indistinguibles de las positivas y, hasta hace muy poco, la falta de artículos en proceedings que son claves en algunos campos.

Algunos índices relacionados con el h son:

- El índice de inmediatez: número medio de citas de artículos en ese año.

- Vida media: la edad media de los artículos que fueron citados en JCR cada año. Por ejemplo, si la vida media de una revista en 2005 es 5, significa que las citas en el periodo 2001-2005 suponen el 50% de todas las citas en 2005.

- El factor de impacto agregado para una categoría: se calcula con el número de citas de todas las revistas de esa categoría y el número de artículos de todas esas revistas.

NUEVOS INDICES DE IMPACTO

En los últimos años han ido surgiendo soluciones alternativas, basadas en las nuevas bases de datos que usan las nuevas tecnologías y permiten desarrollar nuevas herramientas de medición, y en Internet, que permite usar los repositorios de preprints y las páginas web de los autores. Son de tres tipos: (1) Las que permiten buscar en el texto completo (Google Scholar); (2) Las que buscan los artículos relevantes de una especialidad (High Energy Physics; MathSciNet) y (3) Las que imitan a WoS (Scopus).

Arxiv y SPIRES

arXiv es un archivo para preprints electrónicos en Matemáticas, Física, Informática y Biología Cuantitativa, accesible por Internet. Es ya una costumbre para físicos y matemáticos enviar los artículos al ArXiv. En Julio de 2008, arXiv.org contiene 546,860 e-prints, con unos 4.000 nuevos cada mes.

arXiv fue desarrollado por Paul Ginsparg y comenzó en 1991 como un archivo para artículos de Física, que después incluyó también Astronomía, Matemáticas, Informática, Ciencia nolineal, Biología cuantitativa, y ahora Estadística y Finanzas. La denominación e-print se adoptó para describir los preprints electrónicos.

La base de datos SPIRES High Energy Physics (SPIRES-HEP), instalado en el Stanford Linear Accelerator Center (SLAC) en los 70, fue la primera base de datos accesible por la World Wide Web en 1991.

Se amplió a un proyecto conjunto de SLAC, Fermilab, y DESY, con espejos en estas y otras instituciones como el Institute for High Energy Physics (Russia), la University of Durham (UK), el Yukawa Institute for Theoretical Physics en Kyoto University (Japan), y LIPI (Indonesia).

Este proyecto almacena información bibliográfica sobre High Energy Physics y es un modelo de bases de datos académicos y de buscadores.

MathSciNet

MathSciNet es una publicación electrónica que ofrece acceso a una base de datos de reviews, abstracts e información bibliográfica de prácticamente toda la literatura matemática. Cada año se añaden unas 80,000 nuevas entradas, clasificadas de acuerdo con la Mathematics Subject Classification. Los autores están perfectamente identificados, algo que está comenzando a hacer WoK, aunque hay todavía años luz entre ambas soluciones.

Continua la tradición de la versión en papel Mathematical Reviews (MR), iniciada en 1940, se seleccionan reviewers expertos para escribir un review: cada año, se añaden unos 60.000. MathSciNet contiene unos 2 millones de items y unos 700.000 enlaces directos a los artículos originales; debe destacarse que hay datos que van hasta 1864.

MathSciNet ha desarrollado el Mathematical Citation Quotient MCQ, idéntico a WoK pero ampliando a 5 años, más apropiado para Matemáticas. Las citas de autores son relativas a las revistas en la base de datos, y solo se muestra el número total de citas y cuántos matemáticos lo han citado

Google Scholar

Google Scholar (GS) es un buscador accesible libremente que proporciona textos completos. Fue lanzado en beta en noviembre de 2004, e incluye la mayoría de las revistas de calidad que están online.

Es similar a los buscadores Scirus (Elsevier), CiteSeer y getCITED., y también a los buscadores basados en subscripciones Scopus, de Elsevier, y Web of Scince, de Thomson ISI.

GS dice cubrir más websites, revistas e idiomas. Su lema es la cita de Isaac Newton:- «Stand on the shoulders of giants». GS nos permite encontrar copias digitales o físicas de artículos, siempre que estos estén online o en una biblioteca.

SCImago Journal and Country Rank database

SCImago fue desarrollado por las universidades de Granada, Extremadura, Carlos III, y Alcalá de Henares. Usa el algoritmo de Google´s Page Rank (no todas las revistas son iguales, tienen un peso según su importancia), buscando la dualidad popularidad versus prestigio. Así y todo, aparecen en general resultados similares aunque hay discrepancias

El índice h (Índice de Hirsch)

Fue propuesto por Jorge E. Hirsch, físico de la Universidad de California en San Diego, en La Jolla. Su artículo original fue Hirsch, J. E. (2005). An index to quantify an individual’s scientific research output. Proceedings of the National Academy of Sciences of the United States of America, 102(46), 16569-16572.

El índice o número h se define de una manera muy sencilla:

h = número de artículos con al menos h citas

Aunque pensado para investigadores individuales, se está usando para grupos, departamentos, instituciones, revistas…, y ha conocido recientemente una proliferación de normalizaciones y generalizaciones.

Si en 20 años, un investigador consigue un h=20, se consideraría un científico con éxito en su carrera; h= 40, un científico sobresaliente, y h = 60, excepcional. Por ejemplo, el físico matemático Ed Witten tiene h = 107.

En el artículo Hirsch JE (2005). Does the h index have predictive power? Proceedings of the National Academy of Sciences of the United States of America, 104(49), 9193-9198, Hirsch se preguntaba: ¿Cómo predecir los logros futuros de un científico en un determinado momento?, o ¿cómo el pasado puede predecir el futuro?. Su respuesta es el número h, que no sirve para dar un premio o nombrar un académico, pero sí para conceder un proyecto, contratar un investigador o promocionarlo.

Otro índices similares que se usan son estos:

- Índice a (media de las citas de los artículos que contribuyen al índice h)

- Índice g (g es el número de artículos que juntos proporcionan g^2 citas.

- Índice m (es el índice h dividido por el número de años desde su primer artículo)

- Índice h-b

- Índice Ca (de creatividad)

- Números de descargas de un artículo

ÍNDICE DE CREATIVIDAD

Fue introducido por José M. Soler (UAM) y se calcula el número de referencias, n, que un artículo hace de artículos previos, así como el número de citas, m, que recibe posteriormente. Así un artículo que contiene muchas referencias pero solo pocas citas tiene un nivel bajo de creatividad, mientras que un artículo con pocas referencias y muchas citas, indica alta creatividad.

El Índice de creatividad (Ca) de un científico se calcula sumando la creatividad total de cada artículo suyo, normalizando por el número de autores. Soler calculó el Ca de los 10 físicos más citas según Thomson-ISI y este fue el resultado:

Philip Anderson –físico de materia condensada de Princeton, Premio Nobel–, tiene Ca = 36.9.

Witten, del Institute for Advanced Study de Princeton, tiene Ca = 35

Weinberg — University of Texas, premio Nobel 1979– tiene Ca = 29.3.

Las ventajas de este índice es que corrige la distorsión causada por las citas de reviews y las autocitas.

CONCLUSIONES

- Todos los creadores de estos medidas que hemos descrito señalan que deben ser usadas con mucha precaución a la hora de evaluar a individuos en decisiones de gran trascendencia personal (plazas, por ejemplo).

- Ninguno de ellos (ni una combinación de los mismos) debería sustituir a la evaluación del experto sobre los resultados concretos.

- Lo razonable parece hacer un buen uso de medidas numéricas (no solo las obtenidas por un único método) acompañado de la valoración de los expertos.

Manuel de León; Investigador Coordinador de SIMUMAT; CSIC y Real Academia de Ciencias; Miembro del Comité Ejecutivo de la Unión Matemática Internacional.

Excelente artículo. El tema de los índices de impacto, y la evaluación a los investigadores ha llegado a un punto de perversión que no tiene mucho sentido. Yo sigo prefiriendo una "evaluación" más personal; a veces te topas con algunos investigadores que tienen relativamente pocos artículos pero que cada uno de ellos es una auténtica joya. Para mi esos son los investigadores que valen, los que van en contra de la tónica general de tener 1000 artículos donde se repiten las mismas ideas.

[…] h […]